正文

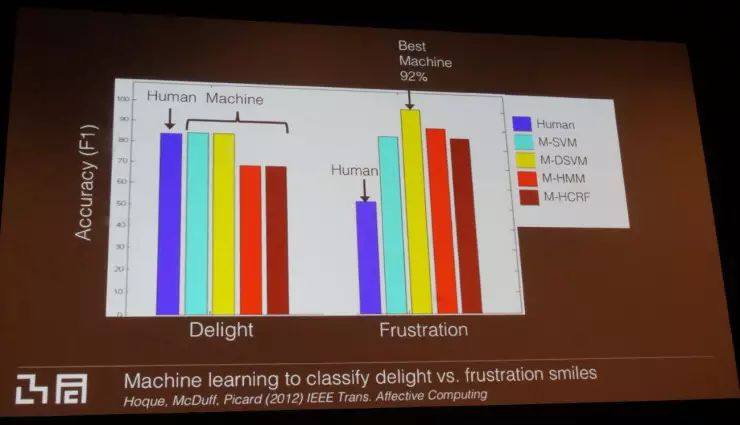

人类和机器学习算法,识别真笑、苦笑的正确率比较

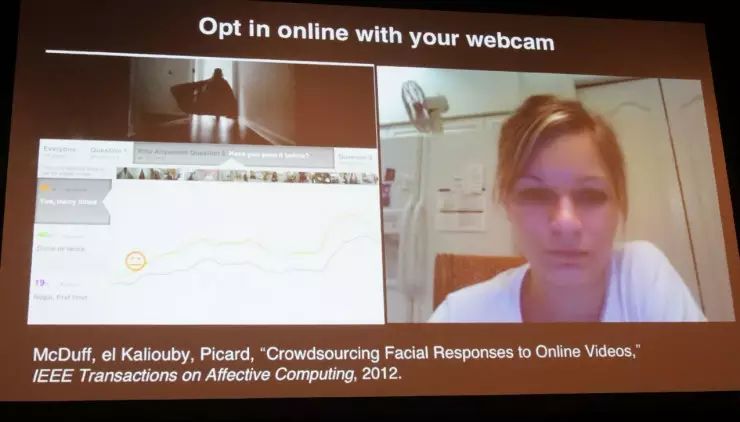

但该研究需要更多的数据,所以我们把许多短视频(包括超级碗 Super Bowl 的视频,都是一些很幽默、喜感的内容,不会让参与者不满)放到网上,邀请人们打开网络摄像头登入观看,分享他们观看时的表情。但这实验中只启用了喜悦笑容的探测。下图左下角的绿线、橙线代表了已经观看过这次些视频的观众,相比首次观看的人(蓝线),他们其实笑地更多。另一个发现是观众发笑的时间——非首次观看的观众,在看到笑点之前就已经有笑的表情。这其实很有趣,这告诉我们,

“笑” 这一行为或许能够揭示人们的过去、以及与特定内容打交道的经历。

人类何时发笑的因素,不止是 “开心”

开发和应用

机器学习开发者们,一直在琢磨如何提升机器学习的成效。我们的实验给开发者社区带来的核心信息是:

相比转换机器学习模型,增加数据量的效果要好得多。

研究中,对于特定(第四)动作单元,真正的提升是在大约 10 万个训练样本之后才发生。第四动作单元是 “皱眉头”(这里指的是眉毛之间起皱纹)——当你聚精会神或对某事感到迷惑、厌恶时的面部活动,很多人眉毛之间都有永久性的“川” 字皱纹。我们开发了一个能根据该动作单元判断情绪表达的检测模型。有用户在很不理想的光线环境下登入测试系统,我们从中获得了很多数据。

如果你想要尝试我们的测试系统,可以在 iOS 应用商店或安卓 Google Play 商店 免费下载,app 名为 “AffdexMe”。

目前,在 24 个面部表情的识别上,AffdexMe 达到了 90% 的精确度,

在印度、巴西和中国、南非、美国、欧洲等地都能下载。我的公司 Empatica 向开发者提供了实时情绪 SDK。如果你需要研究与情绪关联的技术,现在完全免费的(对于研究人员如此。对于商业化应用,在将来未必免费)。

AffdexMe

在面部表情的研究中,我接触到许多患有孤独症的人士。我和我的学生 Steve Mann 开发了类似于谷歌眼镜的设备,并集成了面部表情识别装置。当我戴着该智能眼镜和你说话时,如果你对话题感兴趣并且对我微笑,眼镜屏幕会显示绿色;如果你流露出困惑的神情,我会看到镜片显示的黄色光;如果你流露出负面情绪,我会看到红色光,这向我们提示需要更好地处理谈话。

监测紧张与焦虑

当我与一个患孤独症的年轻女士做实验时,她太紧张与我说话,于是打字对我说:“Ros,你做得不对。你读别人的情绪,对我来说并不是问题,但你读不到我的。” 当时我感到有些受伤,因为这是我赖以谋生的工作。

但她继续说:“并不只是你,所有人都体会不到我的情绪。”

我就说:“大家为什么会体察不出对方的情绪?我们没能从你身上读出的情感是什么?或者,我们读错了什么?” 她说:” 你们感觉不到我的紧张、焦虑。” 我意识到,很多人在高度紧张、心头沉重时,或许其焦虑情绪马上就要爆发,但他自己却没意识到,而是把自己内心关闭,与周遭分隔开。比方说,中学里某老师对一个的男孩子说:“起来!做点正事去”,只是很普通的话。但小男孩却一下子情绪崩溃了,因为他刚被学校开除。如果老师能正确解读这个小男孩的情绪,就能避免类似情况发生。

多年前我们开始做大量情绪检测实验的时候,把这看作是一般性的情绪激动信号,但后来证明它比我们想象的远远更丰富有趣。

对于检测出汗的手掌的技术,过去我们称之为 “galvanic skin response”,如今一般更科学、严谨地称为 “electrodermal activity”(EDA,皮肤电活动),测量皮肤的电导系数(conductance)和微摩尔(micromole)。

在麻省理工的 Media Lab,我们着手开发装备该技术的设备,让测试者七天 24 小时佩戴,监测其数据,希望为情绪崩溃等情绪变化提供线索。Empatica 有两个已经商业化的产品:E4

智能手表

推出已经有一年,专为研究人员收集测试者收据。它已被认证为医疗设备,能收集符合临床要求的数据;另外还有 Embrace

智能手环

,我会随后介绍。

E4 智能手表

我们的兴趣在于,获取能让我们读取自主神经系统(autonomic nerve system)两大分支(“sym

path

etic division” 和 “parasympathetic division”)的数据,它们能呈现出紧张、“fight or flight”(打还是跑)和 “rest and digest”(休息、消化)反应。收集的两大信号会实时传输到移动设备,你能看到皮肤电活动、微摩尔、脉搏(需要按住智能手表),脉搏又可用来计算心率。

除这两大分支(sympathetic,parasympathetic)以外,自主神经系统还有第三个分支:enteric。它很有意思,但现在我们还没有测量的好办法。人脑有数亿个神经元,在人睡眠时会进行无数有趣的活动、还有各种很酷的学习迹象,所以人脑智能研究的成果非常值得期待。但现在的研究重心是逃跑反应(flight response)和 parasympathetic 分支的 “休息、消化”。前者通过皮肤来监测,后者则通常是观察心率图谱中的高频波段。

使用普通

智能手机

监测心率、呼吸频率

由于很多研究有孤独者患者参与,我们经常受到要求,开发他们这一群体易于使用的产品。举个例子,我们研究团队是世界首个利用普通摄像头、计算机视觉技术、时间序列分析(time series analysis)、分解法(decomposition),无需人体接触而根据测试者脸色(雷锋网注:心跳快慢影响面部血液流动,产生面部颜色变化)来读取心率和呼吸频率的算法。

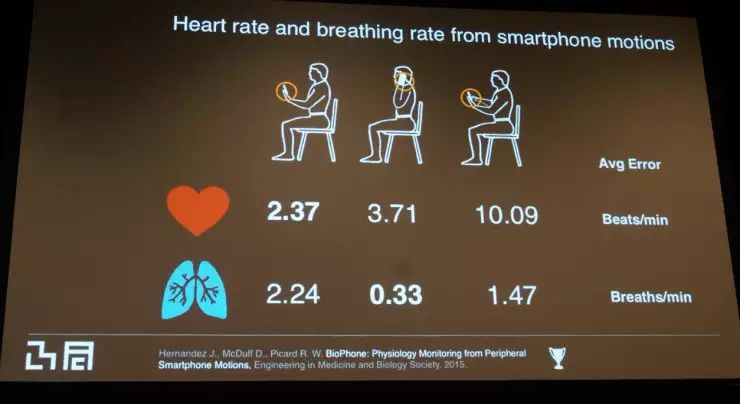

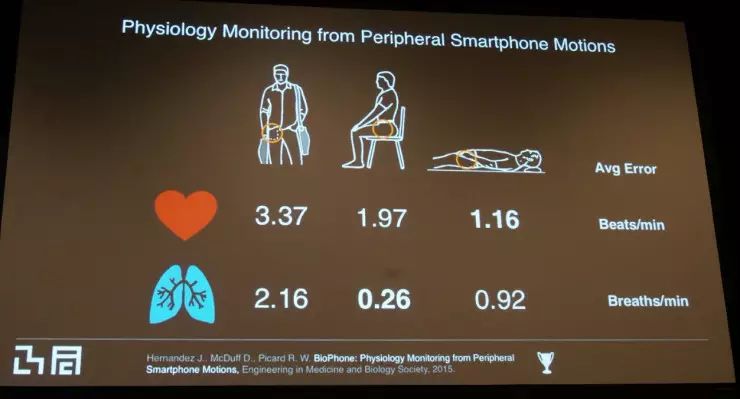

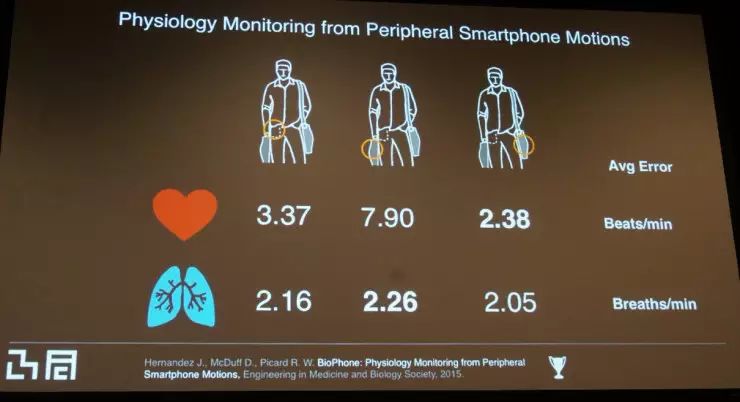

最近,我们在尝试根据你随身携带的物品(例如口袋里的智能手机),读取心率和呼吸频率,而无需佩戴任何设备。我们把该技术的精确率与业界的 “黄金标准”——专业医疗呼吸传感器和 ECG 心率检测设备对比,以下是受试者在不同姿势下的平均误差:

医疗级的手指脉搏传感器(戴在受试者手指)误差在 4 心率 / 分钟左右,而我们的技术平均误差几乎全部在 4 以下,因而可说是十分准确。对于习惯把手机放在手提包里的人们,如果手提包与人体接触有限,仅仅用手提着,误差会稍稍大一些;但如果手提包紧贴于身侧,还是非常精确的。另外,如果你手持智能手机,无论是注视屏幕或是举着它接听电话,监测结果都非常精确。但如果你用手指不停点击屏幕、执行触摸操作,误差会变大,这倒在意料之中。大家请等我们的好消息——

未来会推出能监测心率和呼吸频率的手机 app,而不需要专门的传感器。

用 EDA 监测大脑活动

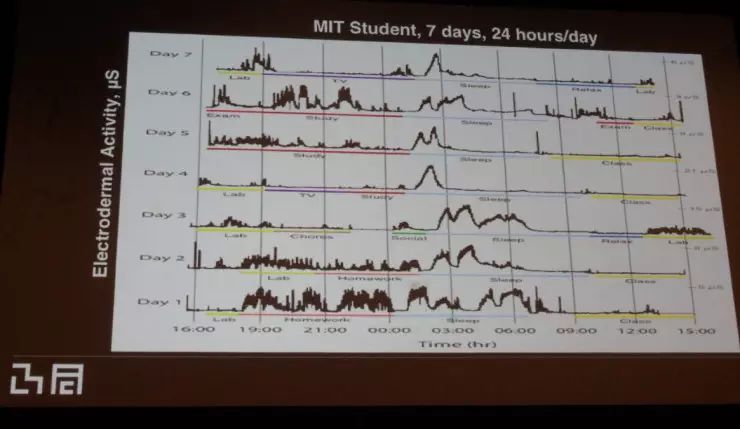

关于 parasympathetic 和心率监测到此为止了,这次讲座剩下的部分将聚焦于 EDA 和电导系数。首先,当下的研究阶段对我来说十分关键——这是我第一次看到测试者七天 24 小时不间断的皮肤电导系数数据,目前测试者全是 MIT 的学生。图中每一行代表着一天。EDA 在实验室工作时段(图中用黄色表示)升高在我们预料之中,这是由于学术交流、认知负荷、情绪负荷、高难度的 MIT 学习和研究(非常难、需要全神贯注的作业)。看电视时 EDA 很低。令人惊讶的是(学生的)社交活动很少,这就是 MIT 的生活(笑)。社交时 EDA 小幅上升,但不及实验室时段。当你只是听别人讲话时,EDA 较低,但当你讲话时,它会上升。

最大的惊讶来自于睡觉时段:这期间的皮肤电活动比一天中其他时段都要高。

不仅 MIT 学生如此,普通人也是这般。我们对此提出了许多研究问题,也发表了许多论文,在这里,我只想指出一点:我们想知道 EDA、EEG (脑电波监测装置,戴在受试者头部) 和 ACC 各自、以及它们之间组合而成的特征,是否都能反映出睡眠时段的大脑活动高峰期。大家都知道,睡眠让人脑子更好使——当一个人学了些新东西然后去睡觉,睡醒后进行测试往往成绩更好。

于是我们进行了标准的记忆巩固、学习、睡眠实验,把睡眠后比睡眠前提升最大的受试者,和提升幅度最小、甚至没有提升抑或降低的受试者进行对比测试。我们创建了一个二元分类器,来看看是否能够使用这些特征,把两组受试者区分出来。迄今为止所发现的最佳特征是六个智能体(agents)的特征,利用六个很简单的机器学习模型进行特征测试。如图所示,我们看到在一组实验中紫色所代表的测试(EDA+ACC);其它所有实验中红色所代表的测试(EDA),最能辨别出睡眠时的大脑高峰活动。