正文

右边这是常用的端到端模型

:

RNN, LSTM, Atention

模型等

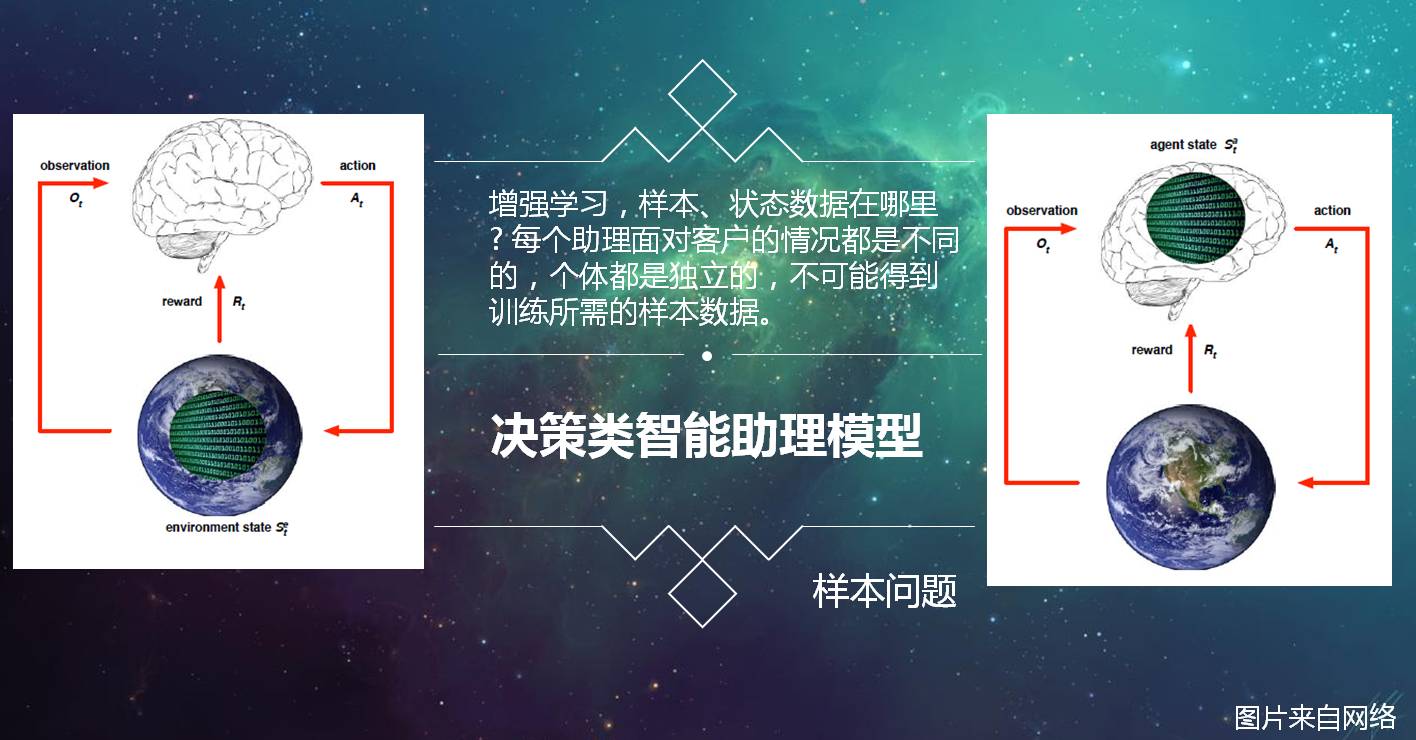

强化学习把学习看作试探评价过程,

Agent

选择一个动作用于环境,环境接受该动作后状态发生变化,同时产生一个强化信号

(

奖或惩

)

反馈给

Agent

,

Agent

根据强化信号和环境当前状态再选择下一个动作,选择的原则是使受到正强化

(

奖

)

的概率增大。选择的动作不仅影响立即强化值,而且影响环境下一时刻的状态及最终的强化值。

而智能助理面对的个人方方面面的任务,事件,无法得到那些专业的正样本数据

,

并且每个助理面对客户的情况都是不同的,个体都是独立的,更不可能得到训练所需的样本数据。

二

理想中的智能助理

之前有篇比较火的智能助理文章《为什么智能助理都像智障》,

“人工智能助理:这里指的是Intelligent personal assistant/agent (IPA)

,指帮助个人完成多项任务或多项服务的虚拟助理”

[2],

如何帮助?在文章

[2]

中,提出对话式助理至少满足这几点功能:

”

具备基于上下文的对话能力,具备理解口语中的逻辑,所有能理解的需求,都要有能力履行。

”[2]

能不能像

YY

玄幻小说中的深山偶获老法师灵体,之后在你修行中的方方面面问题中提供指导。比方《斗破苍穹》中的药老 。

三

理想中的智能助理的可行吗?

接下来是本次分享的一个重点内容,也是一个没有答案的探讨内容。