正文

人脸识别、虹膜识别、指纹识别、指静脉识别,其实都是基于人工智能的一个重要分支:图像识别技术。

小灰灰告诉我:“这些每个人都会用到的身份识别技术,原理都是通过传感器采集信息,然后进入算法。这样,只要知道这些传感器需要“看见”什么,我们就伪造一个给它看。就能轻松欺骗骗过它了。”

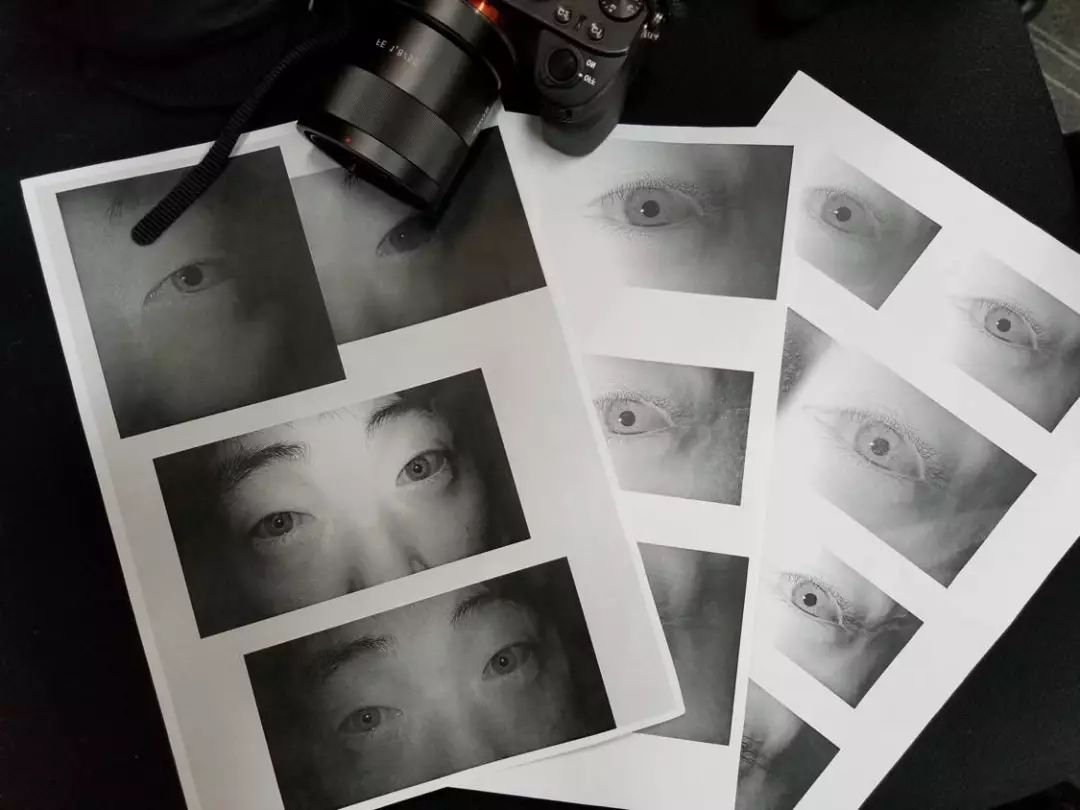

这是小灰灰拍摄的自己的眼睛,用来破解虹膜识别系统。

这也是韩祖利眼中人工智能面临的第一个问题:

“传感器欺骗”

。

单纯的一种验证方式,比如仅仅人脸识别,或仅仅虹膜识别,都存在绕过的技术,所以业内目前的解决方案是“多因子认证”,就是同时采用两种或两种以上的认证方式。同时欺骗两种认证方式,难度就变得大多了。

他说。

2、软件缺陷

大名鼎鼎的 TensorFlow,是谷歌推出的机器学习系统,人人都可以利用这个平台开发自己的人工智能应用。

但是,假设这个架构本身就存在漏洞呢?

韩祖利说:“Tensor有 887 万行代码,不仅如此,要运行 Tensor,还需要调用约 100 个依赖库,其中很多库都是很多年前的“老古董”。这么多代码已经超出了人工审计的工作量,其中一定存在漏洞。”

这张图表里列举了各大人工智能平台的漏洞情况(点击可以看大图)

看看上面这张图,就是各大人工智能平台的漏洞表。不用假设,他们就是有漏洞的。

对于这种漏洞,似乎没有好的方法,就是不断认真审计、查找问题。安全研究员的职责即是在此,至少百度在自家的 Paddle Paddle 人工智能平台上是这么做的。

3、数据投毒

说到数据投毒,是AI攻防里最惊心动魄的部分。也是最接近人们想象的一种。

加州大学伯克利分校的著名人工智能专家 Down Song 算是一个“城会玩”的代表。她

在一个写着“STOP”的标牌上,粘贴了几块胶条。人类看起来这根本没什么,但是在自动驾驶的人工智能看来,这就是一个时速45公里的限速牌。

这些人类看来无关紧要的干扰,却能骗过机器识别,汽车无法识别停止标志,后果将不堪设想。

想象一下,如果你的自动驾驶汽车遇到了这样的标牌,一定会毫不犹豫地冲过去,让你体验从急救车到医院抢救的全套流程。

韩祖利说,这就是标准的

“对抗数据”

。

同样的玩法还有很多,比如日本的一个团队,在每张图片里加上一个像素,就能让人工智能识别产生翻天覆地的错误,直接指鹿为马。(顺便说下,他们搞定的是技术很强的 Face++ 系统。)

在每张图片里,只加了一个像素,就能造成机器“凌乱”,例如把飞机识别为狗,把马识别为摩托车,把大象识别为猫。。。

再比如,如果你欠朋友二十万不打算还,就得去做个整容。但是如果想让人脸识别不认识你,只需要这个特殊的发光眼镜。戴上之后,就会被系统认作另外一个人。

发光眼镜,大概是这意思。。。

人工智能虽然被叫做人工智能,但其实目前的技术根本达不到人类这种完备的知识体系,所以很多在人看来很 Low 的欺骗方法,就可以轻松“撂倒”它。

刚才说的,是对抗已经“成年”的人工智能。还有人做得更绝,在人工智能接受数据训练的时候,就直接把“带毒”的数据混进去,这样训练出来的人工智能就带有天然缺陷。

这就是

“数据集投毒”

了。

毕竟,现在的人工智能就像一个小孩子,小孩子往往是很好骗的。

说到数据投毒,我就想到了蛇精用毒药水养葫芦,出来的七娃就是这个效果↓↓↓

4、系统安全

人工智能系统是要跑在操作系统之上的。而这些操作系统每年都会被“白帽子”找到大量漏洞,打上一串儿补丁。前一阶段爆发的 WannaCry 病毒,没打补丁的电脑就遭殃了。

尤其对于很多携带智能功能的硬件来说,如果操作系统有漏洞不及时补上,就很可能被黑客控制。