专栏名称: CVer

| 一个专注侃侃计算机视觉方向的公众号。计算机视觉、图像处理、机器学习、深度学习、C/C++、Python、诗和远方等。 |

目录

相关文章推荐

|

Supreme情报网 · 原价起飞!「LV阿甘鞋」贵替铺货,仅需920 ... · 11 小时前 |

|

Supreme情报网 · 原价起飞!「LV阿甘鞋」贵替铺货,仅需920 ... · 11 小时前 |

|

物道 · 越来越多的年轻人爱上了焚香? · 15 小时前 |

|

江南都市报 · 优衣库官宣和Labubu联名,上市销售时间为 ... · 23 小时前 |

|

物道 · 一日道|相遇,是一场盛大的回归 · 昨天 |

|

物道 · 风靡一时的“麻将凉席”销声匿迹了?被时代淘汰 ... · 2 天前 |

推荐文章

|

Supreme情报网 · 原价起飞!「LV阿甘鞋」贵替铺货,仅需9200一双~ 11 小时前 |

|

Supreme情报网 · 原价起飞!「LV阿甘鞋」贵替铺货,仅需9200一双~ 11 小时前 |

|

物道 · 越来越多的年轻人爱上了焚香? 15 小时前 |

|

江南都市报 · 优衣库官宣和Labubu联名,上市销售时间为8月29日 23 小时前 |

|

物道 · 一日道|相遇,是一场盛大的回归 昨天 |

|

物道 · 风靡一时的“麻将凉席”销声匿迹了?被时代淘汰,连声招呼都不打 2 天前 |

|

米尔看天下 · 远火旅一轮齐射报销一个坦克团 炮弹值一吨黄金 8 年前 |

|

爱否科技 · 新款小米笔记本确认:支持4G/不是游戏本 7 年前 |

|

不存在 · 马斯克送跑车上天,我向太空发射了一列特快 | 科幻春晚 7 年前 |

|

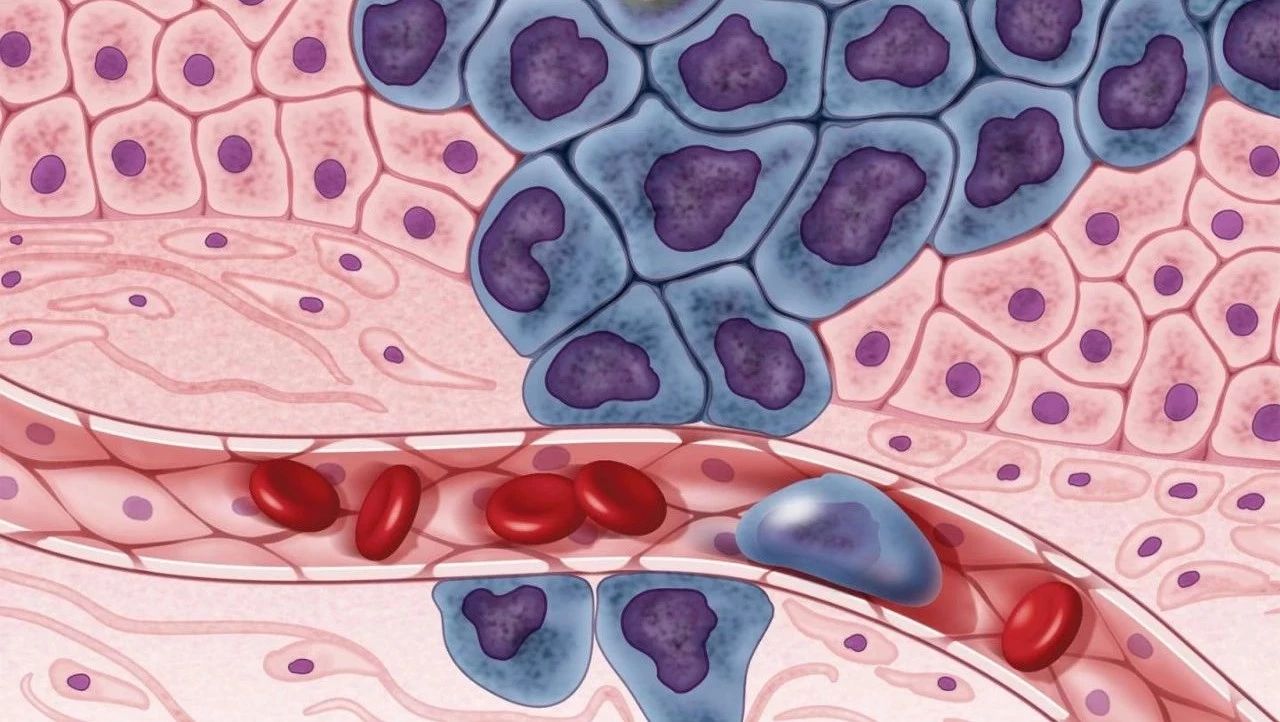

学术经纬 · 超重磅!战胜癌症的道路上,我们前进了一大步! 7 年前 |

|

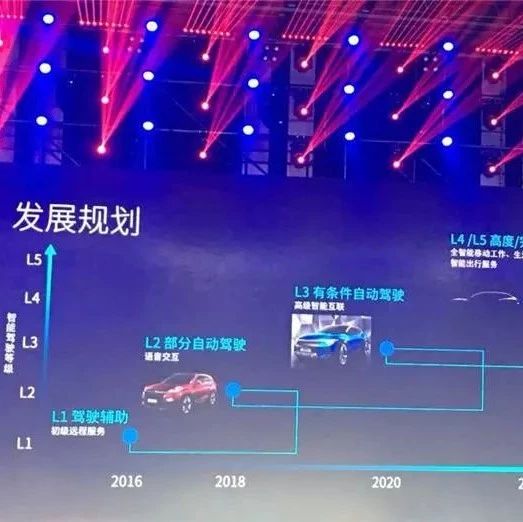

盖世汽车每日速递 · 奇瑞发布“雄狮”智能战略品牌 计划2020年实现L3自动驾驶 7 年前 |