正文

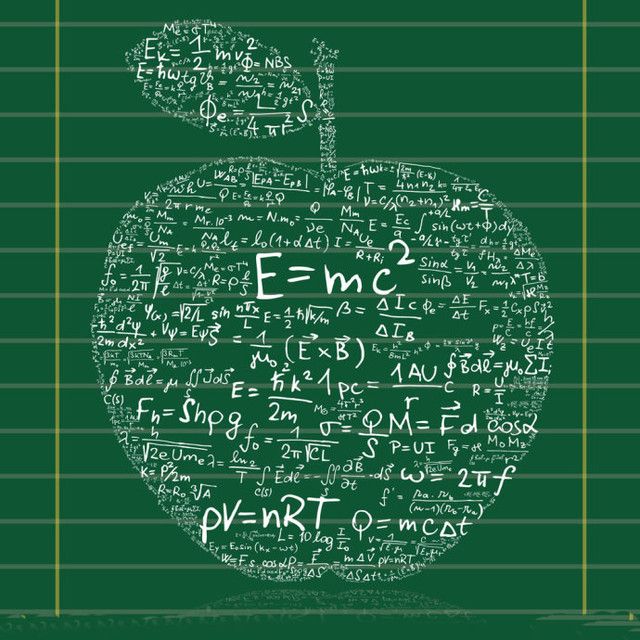

图2 Warren McCulloch和Walter Pitts以及他们提出的模型

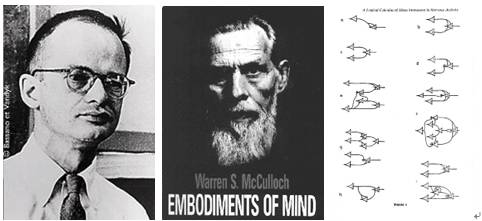

1949年,心理学家Donald O. Hebb在《The Organization of Behavior》中描述了神经元学习法则。

图3 Hebb学习法则

1957年,美国神经学家Frank Rosenblatt在Cornell航空实验室中,他成功在IBM 704机上完成了感知机的仿真。两年后,他又成功实现了能够识别一些英文字母、基于感知机的神经计算机——Mark1,并于1960年6月23日,展示与众。

图4 Rosenblatt和Mark1 感知机

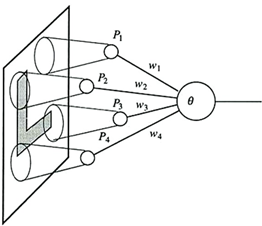

Rosenblatt,在Hebb学习法则的基础上,发展了一种迭代、试错、类似于人类学习过程的学习算法——感知机学习,该算法的初衷是为了‘教导’感知机识别图像。除了能够识别出现较多次的字母,感知机也能对不同书写方式的字母图像进行概括和归纳。但是,由于本身的局限,感知机除了那些包含在训练集里的图像以外,不能对受干扰(半遮蔽、不同大小、平移、旋转)的字母图像进行可靠的识别,即对噪声敏感。

图5 Rosenblatt的感知机示意图

首个有关感知机的成果,由Rosenblatt于1958年发表在《The Perceptron: A Probabilistic Model for Information Storage and Organization in the Brain》里。1962年,他又出版了《Principles of Neurodynamics: Perceptrons and the theory of brain mechanisms》一书,向大众深入解释感知机的理论知识及背景假设。此书介绍了一些重要的概念及定理证明,例如感知机收敛定理。

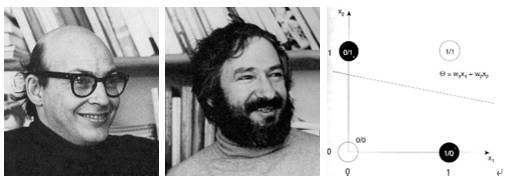

虽然最初被认为有着良好的发展潜能,但感知机最终被证明不能处理诸多的模式识别问题。1969年,

Marvin Minsky

和Seymour Papert在《Perceptrons》书中,仔细分析了以感知机为代表的单层神经网络系统的功能及局限,证明感知机不能解决简单的异或(XOR)等线性不可分问题,但Rosenblatt和Minsky及Papert等人在当时已经了解到多层神经网络能够解决线性不可分的问题。

图6 Marvin Minsky和Seymour Papert及XOR问题

由于Rosenblatt等人没能够及时推广感知机学习算法到多层神经网络上,又由于《Perceptrons》在研究领域中的巨大影响,及人们对书中论点的误解,造成了人工神经领域发展的长年停滞及低潮,直到人们认识到多层感知机没有单层感知机固有的缺陷及反向传播算法在80年代的提出,才有所恢复。1987年,书中的错误得到了校正,并更名再版为《Perceptrons - Expanded Edition》。

在Freund及Schapire(1998)使用核技巧改进感知机学习算法之后,愈来愈多的人对感知机学习算法产生兴趣。后来的研究表明除了二元分类,感知机也能应用在较复杂、被称为structured learning类型的任务上(Collins, 2002),又或使用在分布式计算环境中的大规模机器学习问题上(McDonald, Hall and Mann, 2011)。

假设输入空间(特征向量)为

,输出空间为

,输出空间为

。输入

。输入

表示实例的特征向量,对应于输入空间的点;输出

表示实例的特征向量,对应于输入空间的点;输出

表示示例的类别。由输入空间到输出空间的函数为

表示示例的类别。由输入空间到输出空间的函数为