3D视觉+生物识别,助力iPhone 8实现酷炫全面屏

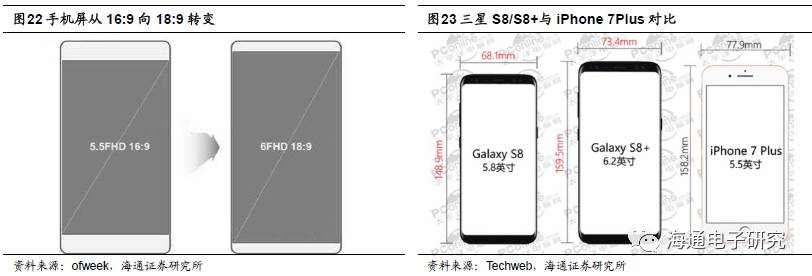

自2016年底开始,手机显示屏的竞争在三星、小米、LG等厂商的推动之下,已经向18:9甚至18.5:9、19:9、20:9的长宽比挺近。特别是小米MIX和三星S8的推出,使得高屏占比“全面屏”已经成为高端手机的最新潮流。

作为全球智能手机的领头羊,苹果公司自然不甘人后,最新款iPhone 8大概率将配备高屏占比显示屏。

2016年底到2017年初,根据台湾供应链(科技时报等)的信息,苹果计划在2017年第3季推出的首款AMOLED手机iPhone8,将采用5.8寸18.5:9的长宽比例亮相,显示面积高达 5.15寸,屏占比高达85%,取消实体Home键。

但是,移除正面Home键意味着苹果旗帜性的指纹识别需要大变化。

目前手机端指纹识别的主流方案为电容式方案,其信号难以穿透0.3mm以上的玻璃,因此现有的电容式方案难以实现屏幕下指纹识别。为了实现全面屏,同时又保留指纹识别,三星便不得不将正面的指纹识别移至背面,这是一种妥协的方案,用户体验是一种倒退。

备受关注的光学式与超声波式指纹方案由于技术不成熟,未通过苹果测试。

与电容式指纹识别相竞争的另外两种方案——光学与超声波,展现出具备全屏幕指纹识别的潜力,但是无论是新思科技重点研发的光学式方案,还是高通力推的超声波方案,都在技术上难以达到苹果的稳定性和成熟性要求,这两种方案还有待技术的进一步成熟。

我们认为,3D视觉结构光方案用于人脸识别可替代指纹识别。

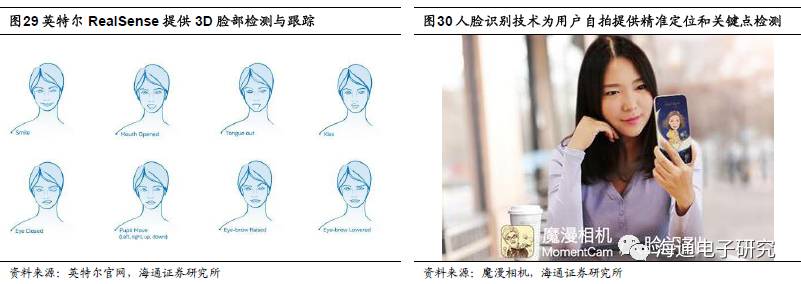

苹果在结构光3D视觉方面积累的技术,给了其放弃指纹识别的信心。采用结构光原理的人脸识别属于高级的三维人脸识别技术,相比于传统的二维人脸识别,在识别精度和速度方面大幅提升,特别是与指纹识别相比,3D人脸识别用户体验更佳,操作更加便捷,因而备受期待。

3D人脸识别不仅仅在识别精度方面大幅提升,更重要的是打开了更加广阔的人工智能应用空间。

例如利用三维人脸识别可以直接获取消费者面部表情(喜怒哀乐等),通过人工智能技术,可计算出用户的生理年龄或精神状态,这些功能都将为消费电子带来全新的玩法;人脸识别还可以用于移动端自拍的快速对焦,用户自拍美颜等功能。

2017年6月WWDC会议上苹果发布了新的机器学习API——Core ML,支持人脸追踪、人脸检测、自然语言处理、文本检测等任务。

Core ML的核心是加速在iPhone、iPad、Apple Watch上的人工智能任务,支持深度神经网络、循环神经网络、卷积神经网络、支持向量机、树集成、线性模型等。

可见苹果在AI人工智能方面具有打造大平台的野心,通过Core ML为广大开发者提供AI机器学习和建模能力,从而使众多iOS终端产品具有AI功能。3D视觉将成为该战略中核心的一环,通过3D视觉硬件可以提供精确的人脸识别、动作捕捉等功能,与Core ML平台形成生态与数据协同。

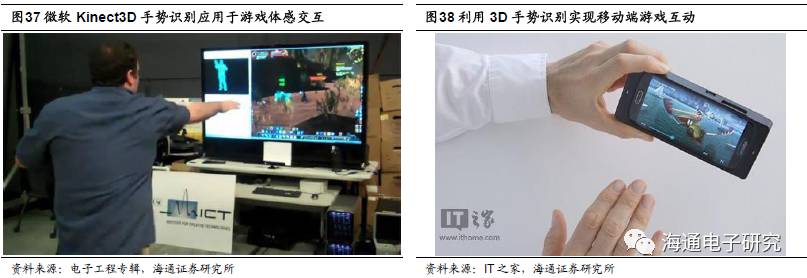

现如今,大尺寸触控显示屏已经是大多数智能终端的标配,无论是智能手机、平板电脑,还是笔记本电脑,甚至于汽车中控台、智能家电等。尽管触控显示屏的识别精度和清晰度越来越高,但是,触控显示屏的局限性非常明显:手指必须接触于屏幕表面,无法离开屏幕工作,这极大地限制了用户的使用空间和灵活性,为了解决这一问题,语音控制与体感控制开始出现,并被广泛看好。

语音识别可以完全解放双手,但是在人机互动方面的应用场景有一定的局限性,对于游戏娱乐、互动体验、拍照等领域,这些必须有用户肢体参与的场景,语音交互无法满足需求。因此,比现今触控屏更高层次的体感交互成为了广大厂商追求的目标。

要实现体感交互,最重要的就是手势识别,因为手部动作是人体最丰富也是最常用的体感动作。

对于智能手机而言,如果手势识别可以得到应用,那么包括手机自拍、游戏、浏览网页、购物等众多应用场景,在用户体验上均可以实现大幅提升,手机也将从触控屏时代走向手势识别时代。

3D视觉的出现为手势识别与体感交互打开了新空间。

(篇幅所限,内容有删减,详见原文报告)

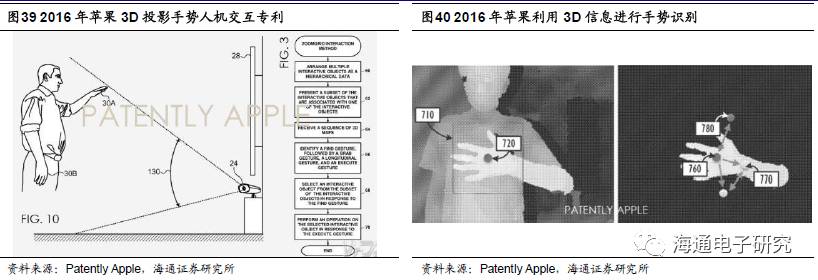

3D视觉将开启移动终端人机交互新方向。

将3D视觉技术与移动终端结合,将开启众多新玩法,如用户通过手部动作直接与游戏进行互动,这将大大提升移动终端的娱乐体验。苹果公司在手势识别方面已经研发多年,在利用3D视觉技术进行手势识别与体感交互方面,已经储备多项专利技术。

3D视觉+VR/AR,苹果打开“虚拟/增强”新世界

3D视觉在VR/AR领域应用空间大,人机交互体验佳。

从2015年以来,VR/AR逐渐走入大众视野,尤其是Oculus、HTC VIVE和索尼PSVR三大VR头显在2016年的先后发布,激活了VR市场。同时,微软在2016年也推出了第一款商用消费级AR设备HoloLense。VR/AR产品在用户体验和应用场景方面带来了颠覆性的改变,人机交互作为其核心的功能成为广大厂商关注的焦点,尤其是手势识别实用性最佳。

例如,2016年Inuitive和gestigon两家公司携手合作,将手势识别功能嵌入VR设备中,其中,Inuitive公司提供NU3000多核心3D影像处理器和深度摄像机,gestigon公司提供手势识别算法;微软AR头显HoloLense,集成了4颗环境摄像头、1颗景深摄像头(基于3D-TOF原理)、1颗高清摄像头、1个IMU(惯性测量单元)、1个环境光传感器,可以提供较为优质的3D手势识别功能。

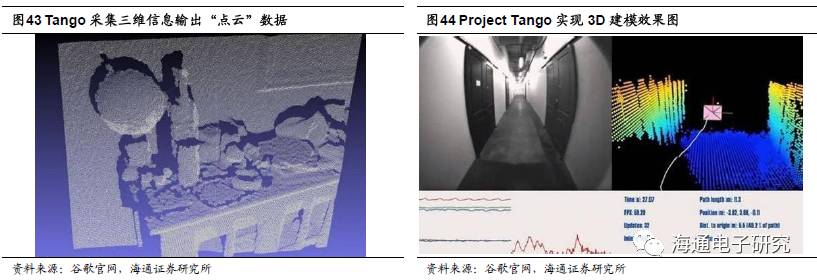

3D视觉在AR领域应用潜力巨大,提供强大建模能力。

对于AR而言,其核心功能是在现实物体上叠加虚拟信息,将真实世界和虚拟世界“无缝”集成,从而为用户提供真实与虚拟叠加的全新体验。因此,在AR众多相关技术中,3D建模是至关重要的,需要借助3D视觉景深相机在现实物体的基础之上构建虚拟的图像画面。

苹果计划未来重点打造先进AR体验,我们认为3D视觉将提供重要支持。

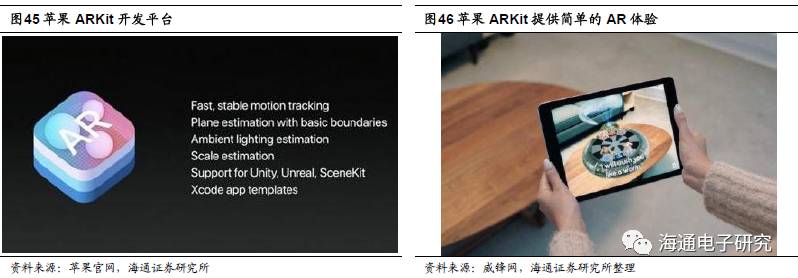

2017年6月WWDC会议上,苹果发布ARKit开发平台,能够利用每一部iPhone和iPad上的摄像头,以及各种传感器,创造出出色的AR体验。凭借苹果庞大的iOS用户群和开发者群体,ARKit一举成为全球最大的AR开发平台。但是,目前该平台主要基于传统摄像头,在AR体验方面与3D摄像头相比有较大差距。

根据独立报的报道,苹果CEO蒂姆库克强调,AR将是苹果未来不可或缺的重要环节,有了AR,苹果的iPhone手机将更加具有吸引力。

库克表示在2017年秋季推出iOS 11后,能看到各种各样的AR应用,目前开发人员正在开发大量基于ARKit的应用和游戏,它们也将于2017年秋季开始推出。

尽管目前ARKit主要利用iPhone、iPad等设备现有的摄像头实现AR体验,但是如果iOS设备添加3D视觉之后,将在AR体验方面全面升级,3D视觉所提供的景深信息和建模能力是现有普通摄像头无法比拟的,借助3D视觉苹果的AR体验将更加出色。