专栏名称: DeepTech深科技

| “DeepTech深科技”是与麻省理工科技评论官方独家合作的一个新科技内容品牌。我们专注于关注三个方面:1、基于科学的发现;2、真正的科技创新;3、深科技应用的创新。 |

目录

相关文章推荐

|

新浪科技 · #泡泡玛特创始人王宁成河南新首富#【河南首富 ... · 昨天 |

|

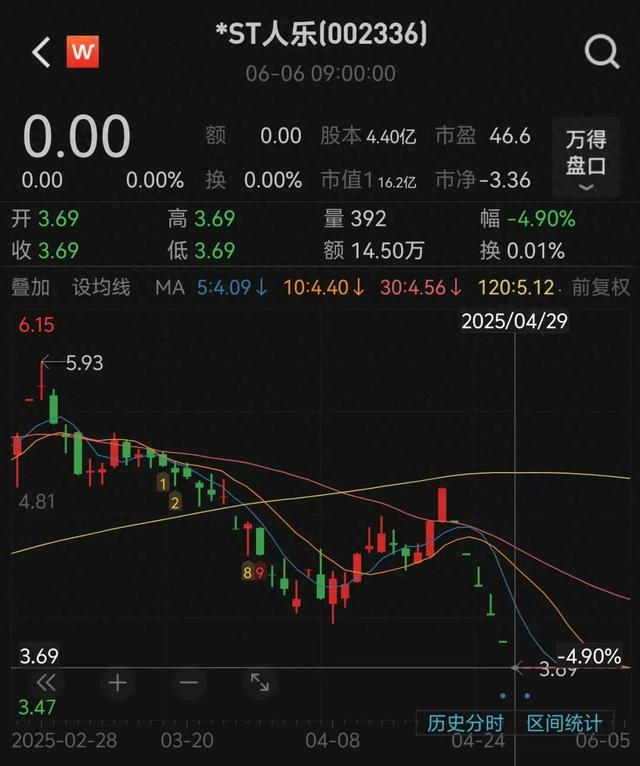

新浪科技 · #民营超市第一股将退市#【知名连锁超市将退市 ... · 昨天 |

|

新浪科技 · 【#央行公布最新官方储备资产数据# ... · 昨天 |

|

36氪 · 我在县城卖茶叶,离不开人情世故 · 2 天前 |

|

|

最黑科技 · 住在半山腰?乌克兰设计师给普京造了个“悬空别墅”! · 2 天前 |

推荐文章

|

36氪 · 我在县城卖茶叶,离不开人情世故 2 天前 |

|

|

最黑科技 · 住在半山腰?乌克兰设计师给普京造了个“悬空别墅”! 2 天前 |

|

硕士博士读书会 · 这姐们,在老公出轨当中嗅出了商机,离了婚,开了一家特别的公司… 8 年前 |

|

扬子晚报 · 8只扇贝1048元!女子吃饭遇天价扇贝,但这次网友似乎站了店家 8 年前 |

|

新疆949交通广播 · 高考考生必看!今年高考录取有新变化! 8 年前 |

|

不贱不散 · 就你这智商,注定孤独一辈子啊! 7 年前 |

|

全民较真-腾讯新闻 · 福寿螺美味又吉利?别被它的名字欺骗了 | 较真Weekly 7 年前 |