正文

他们认为,假如未来哪一天AI模型通过了这个测试集,就表明它以及达到了AGI

(通用人工智能)

的水平,所以起了这么个听起来很咋呼的名字。我们

同样来稍微感受下题目的难度:

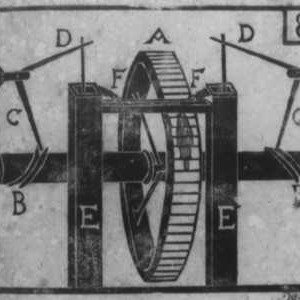

问题1.

上图是一段最早发现于墓碑上的罗马铭文的拓片,请翻译成帕尔米尔文。所提供的文字音译为:RGYNᵓ BT ḤRY BR ᶜTᵓ ḤBL。

©️

Henry T,Merton College, Oxford

上图是一段最早发现于墓碑上的罗马铭文的拓片,请翻译成帕尔米尔文。所提供的文字音译为:RGYNᵓ BT ḤRY BR ᶜTᵓ ḤBL。

©️

Henry T,Merton College, Oxford

鹱形目下的蜂鸟有着一块两侧对称、独特的椭圆形骨头,是一块嵌入在尾部下压肌扩展的十字状腱膜的尾外侧部分的籽骨。请问这个籽骨支撑着多少条配对的腱?

©️

Edward V,Massachusetts Institute of Technology

即便是作为一个通过了无数次人机验证的真实人类,我依旧感受到了连题目都读不懂的学识碾压。而在目前受试的各位AI考生中,

GPT-4o以3.1%的准确率垫底,DeepSeek-R1的准确率是8.6%,而GPT-o3-mini (high)则以14%的准确率名列榜首。

不过该团队认为,鉴于当下AI的快速发展,它们很可能在2025年底前超过50%的准确率。只是不知道到那一刻,人类又会如何出题。

***

我们似乎正以各种方式摸底AI,一方面是小学难度的数学题,另一方面则是最前沿的学术知识,这可能是只属于这个时代的割裂感。

而之所以会出现如此局面,则是因为

AI的答案基于机械匹配而非推理思考

。目前为止所有的大语言模型,其核心原理都是基于统计概率上的模式匹配。简单来说,它们通过学习大量的文本数据,根据不同单词、短语或是句子共同出现的概率来预测下一个“最应该出现”的词汇,从而组织成回答。

用最简单的数学题“1+1=?”来打比方。

AI并不是通过逻辑推理得出的结论“2”,而是它记录了所有“1+1=?”这道题的答案,发现绝大多数都是“2”,所以会告诉你“1+1=2”。

这跟人类的逻辑推理完全不一样……吗?

还记得你是怎么知道1+1=2的吗?

在你上幼儿园之前,总有个人一手抱着你,一手指着窗外的麻雀

(或者桌上的苹果)

让你数数,告诉你那叫作“1”,两个“1”在一起叫作“2”……

而如果连“1”都没有,则是孤零零的“0”。

© Open Horizons

© Open Horizons

但实际上,学术上证明“1+1=2”则要复杂许多,阿尔弗雷德·诺思·怀特海(Alfred North Whitehead)和伯特兰·罗素(Bertrand Russell)两位数学巨擘在100多年前基于皮亚诺公理和类型论,使用一阶逻辑,通过300多页的逻辑推导才证明了“1+1=2”。这个著名过程叫做 “怀特海-拉塞尔证明”

(以上是AI告诉我的)

。

© The Universe of Discourse

© The Universe of Discourse

换句话说,某种意义上,

我们之所以知道“1+1=2”,最初也是基于小时候的一次次“机械匹配”,即重复的记忆

,毕竟还没有听说过哪个学龄前儿童能独立完成怀特海-拉塞尔证明。

既然我们认为AI的答案是机械匹配的结果,那又为什么对我们自己的意识真实性充满自信?

机械匹配和逻辑推理虽然是两码事,但如果我们只将后者视作真正的思考过程,而将前者视作电信号的物理学必然,则多少有点又当裁判又当运动员的意味了。

毕竟在这种语境下,何谓“思考”,我们独占了定义权。

© IconScout

© IconScout

关于意识的讨论也是类似的情况。我们至今连“什么是意识”都尚未达成共识,哲学、心理学、神经科学各有论调,因此当下关于“AI是否会具备意识“的讨论仍像是在暗夜行走,虽有些许亮光,却依旧举步维艰。

不过,在这些亮光中,DeepSeek

(下文缩写为DS)