正文

深度学习最早有一点点借鉴这种思想,也可以把人工神经网络做成很多层,像这个例子里面,有一个Convolution层、有LRN(Local Response Normalization)层、有Pooling层、有Classifier层等不同类型的层。但是随着深度学习的发展,不拘泥于过去这些生物的限制,人的大脑实际上只有六层,而现在的深度学习技术可能就是上百层、数百层甚至有上千层的网络。

深度学习工作方式和应用

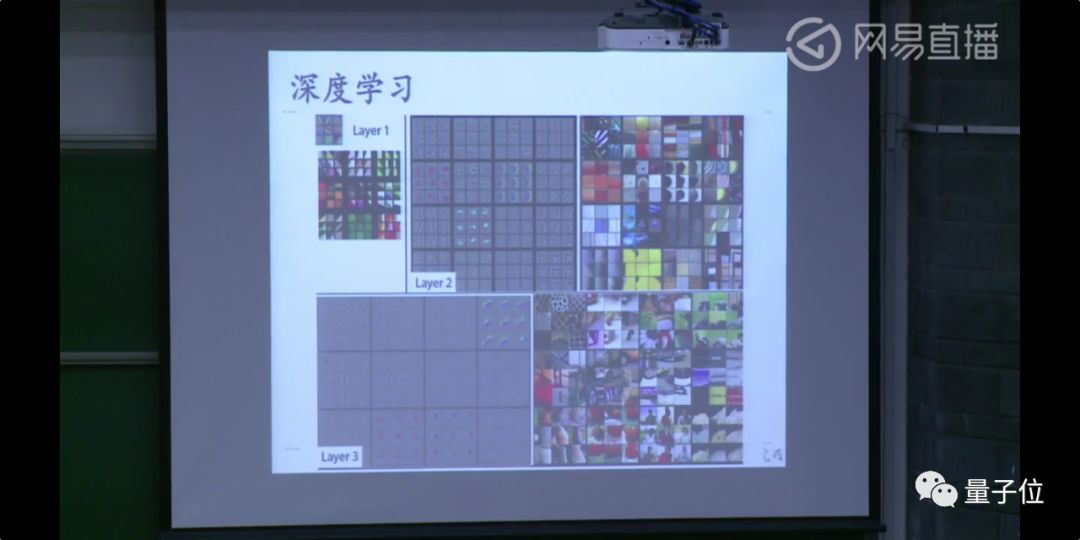

看一个简单的图例,深度学习到底是怎么工作的。

比如说在这个图例里,我们可能是一个5、6层的神经网络,第一层可以看到一些局部简单的特征,比如对角线这样的东西;再下一层神经网络做了一个更大范围的卷积,会看到一个更大范围、更复杂的特征,比如说由环、圈、点这样类似的东西;到下一层我们可以看到更大范围更复杂的。

进行逐级抽象之后,就可以对一个复杂的图片进行理解,比如猪、狗、猫等这些东西,像ImageNet、语音、自然语言处理里都有非常多的比赛、挑战赛,现在基本上是深度学习在主导着这个榜前几名。

这里有一个很著名的测试,用深度可以达到99%的准确度,不仅仅像MNIST这样简单的问题,还有像比较复杂的问题,比如人脸识别。机器在某些特定的工作条件下、边界条件下,可以达到比人识别人脸更高的程度。但是从鲁棒性条件来说,深度学习和人还是有一点点的差距的,但是这个差距我觉得是技术上弥补的,可能需要五年或者更长时间。

另外是语音识别,语音识别现在大家用的已经非常多了、已经是一个非常工业化的技术了。举个例子比如说科大讯飞的语音输入法,实际上这里面都是在用深度学习的方法在做支撑。

2014年DeepMind就已经提出了一套深度学习加增强学习的框架,这里面的含义就是说深度学习就是一个人工神经网络,但是这些人工神经网络的拓扑、参数、权重是怎么得到的呢?它是通过增强学习这套框架不断在现实中学习、调节、不断在自然界中去使用神经网络,然后计算机再返回去调整这个神经网络的权重。

当时DeepMind用它去教会了计算机打很多种小游戏,大概有几十种。比如贪吃蛇这种游戏,用这套框架,DeepMind就告诉计算机,只需要看着屏幕,只需要把这个游戏的分数打得尽量高,不需要告诉计算机游戏规则是什么。

DeepMind让计算机学会了打40多种小游戏,而且有20多种超过了人类的世界记录。然后,DeepMind又把这套深度学习加增强学习的框架用到了下围棋方面,如大家所知,AlphaGo战胜了很多人类世界冠军,他们再把这套框架应用在更多的不同类型的棋类游戏里,都纷纷战胜了人类的顶尖选手,所以说DeepMind的这套深度学习加增强学习框架是非常了不起的。

芯片与神经网络

我们为什么要做专门的芯片来支持神经网络的应用呢?

其实原因很简单,现在的芯片,比如说CPU、GPU,在进行深度学习处理的时候,效率是比较低下的。

从CPU的角度来说,2012年,有个非常知名的工作——谷歌大脑,谷歌大脑当时用1.6万个CPU核跑了接近一周去训练识别猫脸,这个工作当时在NIPS引起了非常大的反响,因为它把猫脸或者人脸识别的准确度显著地提升。但是从另外一个角度上来看,它需要的计算资源太多了,并不是一个普通人、一个普通的企业,能够有这么多个CPU核去跑这么复杂的任务。

另外一个例子是AlphaGo,它在跟李世石下棋的时候,当时用了1000多个CPU和200个GPU,平均每块电费就需要接近3000美元。这反映了一个很实际的问题:现在人工智能算法的能耗实在是太高了,不管CPU还是GPU,都不足够把这些算法真正地用起来。

我们期望智能时代的到来,期望大量智能应用能够落地,这里面一定要有一个前提:物质载体要成熟。

但是从现在来看,不管是CPU还是GPU,不管是性能还是能耗,现在芯片都不足以支撑。

另外还有一个更加长远的问题:现在最复杂的人工神经网络算法,里面的突触多达1000亿多个,但是跟人的大脑相比还是有很大差别——人大概有百万亿个突触。

这是一个从老鼠到米老鼠的比较,我们这里的1000亿个突触是指人工神经网络里的,而百万亿个突触是人脑里生物神经元的突触,可能这两者之间不能划等号,但是它毕竟体现出了一个数量级的差别。

所以专门的人工神经网络处理器或者说深度学习处理器在未来不管从学术角度还是产业角度发展来看都是必然的事情,未来的每台计算机都需要一个专门的深度学习处理器。

寒武纪的发展

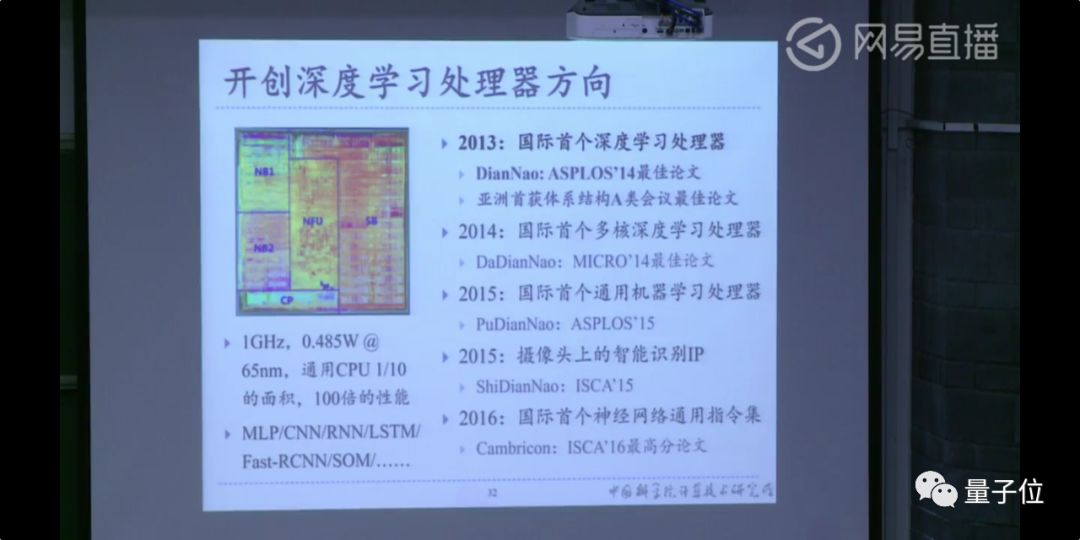

我想这个是跟GPU具有同样规模的潜在市场,非常幸运的是我们中科院计算所走得比国际同行要相对早一些,从2008年开始我们就开始做这方面的研究,团队的名字就叫做寒武纪。

这些是我们具体做的一些工作。

2013年我们做了国际上第一个深度学习架构,这个工作获得了ASPLOS最佳论文奖,这是在亚洲地区,在计算机体系结构顶级会议上的首次拿奖。

这个工作实际上是在通用CPU十分之一的面积上做到了它百倍的性能,后来做了一系列相关工作,包括国际上第一个多核深度学习处理器、国际上第一个商用深度学习处理器等等,获得了一批顶级会议的最佳论文。

应用

目前我们有了一些比较广阔的应用,主要包括云服务器和手机等几个方面的应用。

现在华为的一些高端机型,比如Mate系列、P系列、荣耀V系列都集成了寒武纪的深度学习处理器,为它提供了本地实时智能处理能力。华为在上面做了好多应用,比如拍照时候识别出来你拍了什么东西,可以自动调节光圈、快门等,这些跑在寒武纪深度学习处理器上时,你就不需要联网了,可以实时本地完成这些任务。

除此之外还有一些云服务器的应用,和阿里、联想、中科曙光等这些企业都有合作。

寒武纪的学术贡献

在做深度学习处理器的过程中,我们在学术上还有一些贡献。