正文

AI的普及

现在很多AI仍然在To B的业务里面发生作用,比如金融领域、零售领域的后台、搜索网站的后台、新闻网站的后台,有很多AI算法在工作,如果它能够很顺利地往医疗、个人日常生活发展,就能够普及。这个普及的要求是性价比要高,这对算法、芯片都提出了很高的要求。

未来AI会在四大方面发生作用

对于AI能够在哪些方面发生重大作用,我们有一个总结,有四个方面:

第一是加速。

深度学习

深度学习在图像识别、语音识别上应用使其能力变得很强,在某些具体领域甚至超过了人。这里面的加速在哪里?它可以在某些方面代替人去做事。

举个电商的例子,电商的后台有很大的压力,特别是双十一、618这种特殊时期,会有上传大量的交易的图片、数据,而这些图片都需要被检查,检查其中是否有一些敏感、不当的内容,这些工作靠人是很慢的。Intel和京东在前年双十一合作过,用前年的技术就可以在图片检测上提升4倍,在图片版权保护应用上也有2倍多的提升,这就是完全替代人来做。

视觉的处理

对于视觉理解,现在人工智能算法可以识别一个图像里面有没有人、有没有车等等,但是我们希望识别以后还能够理解这里面发生了什么,这样才可以替代人去做更多的事情。

人实际上是从很多种信息中去获取一些感知、理解所需要的元素,视觉是一方面,声音是一方面,配合视觉里的文字——这种高度语义的线索,这些都结合起来还需要加上一些先验的知识。

比如一个无人驾驶的车,这个车要眼观六路,不同地方发生的事情要有不同的线索去理解,所以算法也要针对不同位置,不同时间发生场景进行描述。

上图图片底下的文字和视频内容的匹配,都是计算机程序自己产生的。不同场景会产生不同的说法,有一些描述不那么美,但信息都在,用这个信息就可以对视频进行场景分析。

第二是探索新领域。

举个例子:探索太空,每天科学家都会收集到非常多的来自太空的探测数据,这些数据杂乱无章,如果靠人去分析,工作量很大,但是如果建立一个模型,把数据导进去,或许很快就能够发现其中的端倪。

灵感

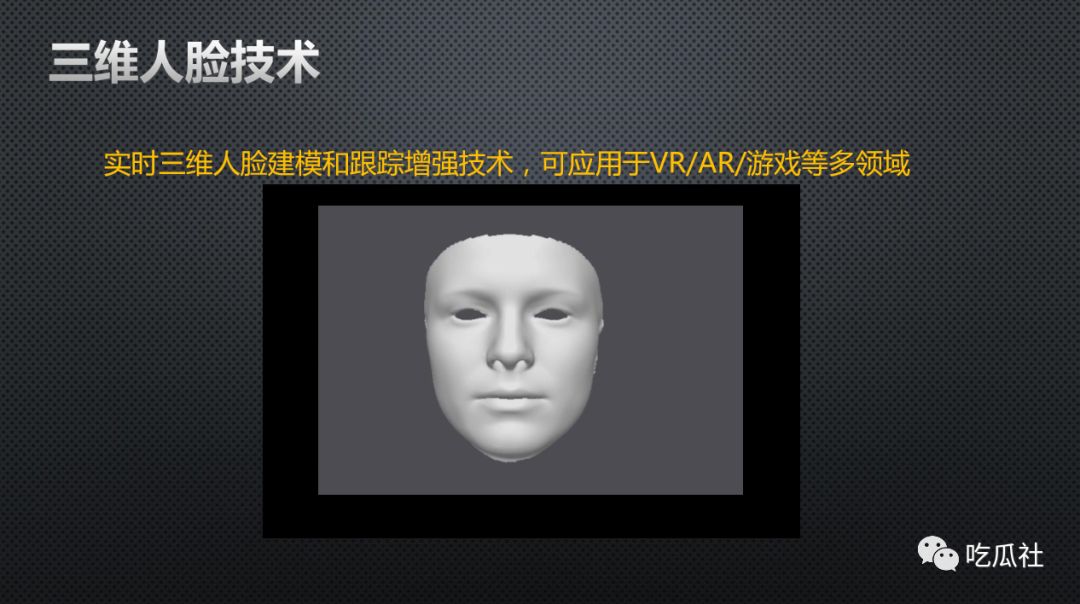

从人脸这个角度来分析,人脸是做算法用的最多的。首先看看跟艺术挂钩,比如风格转化,给定一张商务照或者标准照,再拿一幅画,对肖像里面各个部位进行很好的区分理解,并且把相应位置的一些风格特色提取出来,然后把它映射到这副画上,形成风格迁移。

还有二维进到三维,在二维里能够实时把人的轮廓、特征点检测出来,并且有办法把它映射到三维人脸上去,那么就可以用训练出来的这个三维人脸的模型去基于二维图像中的人脸做任意的叠加、变形和特效。

第三是扩展。

比如说对听力不好的人,可以转换成视觉信息来补足。通过智能翻译扩展人的外语能力。还包括制作外骨骼来帮助不能走路的人,等等;

增强

增强这一块,举一个关于衣服的例子。左边这一件叫蝴蝶衣,这件衣服中用了一些超小型处理器放在小的蝴蝶里,

这些蝴蝶停靠在衣服里,当它检测到人的一些特殊生理信号时它就可以飞起来

。这是一种非常好的展示,可以给服装增强时尚的魅力。

第四是自动化。

机器人、自动驾驶、无人机,这些都是在帮助人完成一些受体力限制,或者肮脏、有毒等一些环境不好的任务。

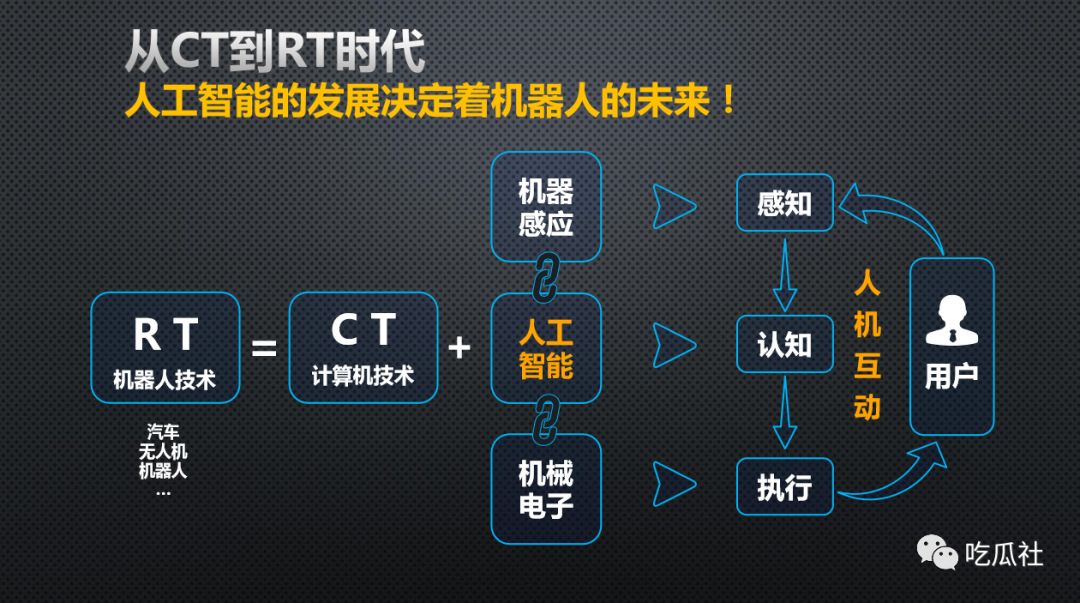

机器人时代

自动化是跟机器人时代有关系的

,过去的时代我们统称为计算机时代(CT,Computer Technology)为主,然后到了Robot Technology时代,它需要在计算机时代里增加几样东西,感知能力要提升,所以有很多传感器技术要加上人工智能技术去帮它感知外部世界。

认知这个部分很重要,感知进来以后要知道发生什么,就需要认知,认知这方面对人工智能的挑战是最大的。下一步是执行,执行层面是借用以前机械电子这方面的积累,把它们都结合起来,让它们和人互动,形成一个交互的闭环,这样才能很好地把一个机器人技术串起来。

不管是无人车还是服务机器人,它们都需要把这个闭环做出来,都是要从计算机这样一个系统架构下增加这三样技术。

人机交互方式也需要有比较大的改变。

现在我们的判断是这样:目前我们已经过了智能这个阶段,现在在朝着自主方面去进军。

从智能到自主,我们需要有更多的传感器数据。但是数据多了,响应的延迟还不能放松,仍然需要保持很快的响应速度,所以对于计算的要求进一步提高。