正文

到另一有某种联系和相似性的新领域,不一定需要那么多数据来学习。现在,基于样本、特征、参数、模型、关系的若干种迁移学习方法正在深入研究之中。

人类具有迁移学习的能力。学会一门外语,学第二门外语就比较容易;会打羽毛球的人,学打网球就不难;精通吉他的人,学钢琴比没有音乐基础的人更快;会骑自行车的人,骑电动车很容易掌握。如此等等。人类具有的迁移学习能力,未来机器也应该有。

挑战摩尔定律

与机器学习和数据科学一样,计算能力的提高依然是推动AI蓬勃发展的强劲动力。摩尔定律曾经造就了信息技术的繁荣,为AI走到今天铺平了道路。虽然摩尔定律已经放缓脚步,或者说已经开始失效,但人类未来依然没有放弃对获得强大计算能力的追求。

英特尔创始人之一戈登·摩尔(Gordon Moore)提出的摩尔定律在不同时期有不同的表述,大约是:价格不变时,集成电路上容纳元件的数量,每18个月翻一番,性能也同时提升一倍。由于物理规律的限制,集成电路元器件密度现在已经不能像过去几十年那样的速度增加。但芯片性能的提升,还有其他途径。

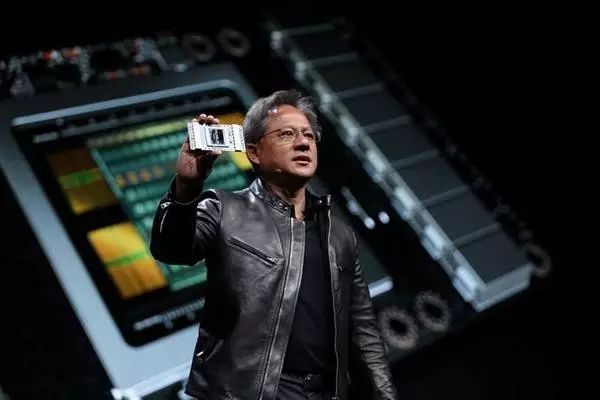

以GPU促进了深度学习发展的英伟达,在2017年的5月的GPU技术大会(GTC17)上,宣布推出新一代GPU。这款名为Volta(伏特)的深度学习芯片,被英伟达称为是通用并行计算架构CUDA发明以来,这个时代最大的技术飞跃。它集成了211亿个晶体管,采用12纳米集成电路工艺生产,支持120万亿次浮点运算。借助专门用于深度学习的运算器,Volta与去年推出的前一代GPU Pascal架构相比,AI训练速度是2.4倍,推理速度为3.7倍。更有人计算出,Volta的最高浮点运算能力,比Pascal GPU架构高5倍,比两年前所发布的Maxwell架构高15倍,性能跃升幅度,大约是摩尔定律描述的4倍。

英伟达推出的新一代GPU:Volta

另辟蹊径挑战摩尔定律的还有谷歌。同样在2017年5月,谷歌在I/O 2017大会上宣布推出新一代深度学习芯片TPU(张量处理器)。有人分析过,TPU代际性能提升幅度约为摩尔定律的3倍,同样跨越摩尔定律定义的发展规律。

半导体工业自身也没有因为摩尔定律可能失效而停步。2017年6月,IBM公司宣布了半导体方面的重大新突破,研制成功5纳米芯片。这种新一代芯片每片可容纳300亿晶体管,速度比目前最先进的10纳米芯片快40%,节能提高75%。可能在2020年投产的5纳米芯片,会大大提升CPU、GPU、TPU等常规和非常规计算芯片的性能。有人把这样的成功称为摩尔定律的延续。

AI发展不可或缺的计算能力,未来仍在大幅提升。

向人脑学习

AI的初心正是要探索人脑奥秘,研究人类思维规律,然后让机器实现人脑的功能。正是怀抱着这样的理想,人类开始了伟大的AI历程。

在AI发展过程中,AI科学家常常受人脑工作机制的启发,神经科学家对人脑研究的成果,也往往为AI研究所借鉴。从人工神经网络发展到深度学习,就是很好的例子。尽管今天的AI技术相对具有独立性,以致有人认为AI与人脑没有太大的联系,但无论是AI科学家还是神经科学家,都保持着对人脑这一宇宙精灵的高度尊敬与重视,期盼对人脑的深入研究,能够在未来AI发展中发挥重要作用。

复旦大学类脑智能科学与技术研究院院长冯建峰教授列举了脑科学与类脑人工智能的四个研究方向:一,大脑神经网络分析。用现代生物学手段采集遗传、分子、神经元等多模态的脑影像和各种数据。用高维大数据新算法,辅助解析大脑工作和信息处理机制,尤其是神经元集群的学习与记忆、抉择、语言等认知功能的机制,加深对大脑信息处理机制的理解。二,认知机制计算模型。研究脑系统的数学模型,尤其是神经反馈连接作用、认知和学习功能,设计新型高效的类脑人工智能算法。三,类脑智能算法创新。用生物学发现来创新或改进己有深度学习计算框架和相关理论。四,类脑智能技术应用创新。发展新的智能控制器和各种智能设备。

这样的研究方向描述,是脑科学研究应用于AI的一张路线图。